De la lansarea publică de anul trecut a GenAI, oamenii din întreaga lume l-au folosit pentru a cerceta, a spune povești, a compune eseuri, a crea muzică și artă și pentru a scrie cod software. ChatGPT, popularul chatbot de la OpenAI, a avut nevoie de doar două luni pentru a ajunge la 100 de milioane de utilizatori activi lunar, ceea ce o face cea mai rapidă aplicație pentru consumatori din istorie.

Dar ce se află în spatele GenAI și a infrastructurii AI – hardware-ul, software-ul și firmware-ul care face totul să funcționeze? Odată cu adoptarea rapidă a GenAI, titanii cloud-ului sunt acum „titani AI”. Asta pentru că pentru a-i sprijini cu succes pe cei care folosesc GenAI, acești titani trebuie să suporte sarcini interne incredibil de mari. Ei au cantități mari de date pe care modelele de limbaj mari sau LLM-uri pot fi folosite pentru a avansa tehnologiile AI în domenii precum asistenții virtuali, chatbot-urile și motoarele de recomandare.

În sprijinirea afacerilor comerciale, există o gamă în creștere de noi domenii în care LLM-urile pot juca un rol, cum ar fi operațiunile cu clienții, managementul lanțului de aprovizionare, cercetarea și dezvoltarea și securitatea cibernetică. Deoarece LLM-urile sunt instruite pe seturi vaste de date, infrastructura AI necesită acceleratoare de calcul specializate care sunt interconectate pentru a forma clustere masive.

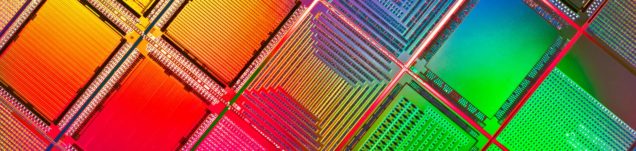

În lumea infrastructurii hardware, majoritatea oamenilor cunosc GPU-uri –

unități de procesare grafică de uz general. Apoi există XPU-uri, unități specifice aplicației „X” care devin critice pentru infrastructurile AI. XPU-urile specifice sunt numite acceleratoare AI personalizate pentru că, literalmente, asta sunt: cipuri personalizate care oferă puterea de procesare pentru a conduce infrastructura AI.

Companiile care rulează infrastructură AI doresc un XPU personalizat atunci când au sarcini interne critice pentru anumite aplicații. Prin personalizarea arhitecturii acceleratorului lor, lățimea de bandă IO (XPU la XPU) și lățimea de bandă a memoriei sunt capabile să proceseze acele sarcini de lucru ale aplicațiilor la volume mai mari, mai eficient decât cu siliciul general.

Beneficiile acestor cipuri personalizate pot fi explicate printr-o ecuație simplă: performanța împărțită la costul total de proprietate sau TCO. TCO este suma costului cipului, al puterii și al infrastructurii care îl pune împreună.

Broadcom lucrează cu clienții pentru a-și personaliza arhitectura, astfel încât aceștia să își poată maximiza performanța infrastructurii AI și a sarcinilor de lucru interne. Optimizarea hardware-ului duce, de asemenea, la o amprentă mai mică, mai puțin costisitoare și redusă. Clienții care se angajează cu Broadcom pentru a dezvolta împreună aceste cipuri personalizate tind să economisească miliarde de dolari în cheltuieli de capital, deoarece sunt proiectați să funcționeze exact așa cum au fost planificați, cu raportul corect de accelerator, lățime de bandă de memorie și lățime de bandă I/O. Optimizarea hardware-ului pentru infrastructura AI înseamnă, de asemenea, reducerea puterii și, prin urmare, a costului total al acestor cipuri personalizate. Luate împreună, aceste avantaje se combină pentru a face din Custom XPU soluția financiară și de inginerie ideală pentru AI pentru consumatori.

Cipurile AI personalizate au în esență patru straturi: calcul, memorie, I/O de rețea și o tehnologie de ambalare fiabilă. Arhitectura complexă, împreună cu complexitățile în ambalare, ne obligă să ne uităm la ceea ce doresc clienții companiei să realizeze cu sarcinile lor de lucru AI – trei, cinci și chiar 10 ani în viitor.

Lucrând cu clienții, au dezvoltat, optimizat și automatizat un flux pentru a construi acceleratoarele cât mai mici, rapide și cu spațiu cât mai mic posibil.

Aceasta este o responsabilitate comună deținută atât de Broadcom, cât și de

client. Broadcom deține stratul de memorie. Compania crează soluțiile potrivite de memorie, conectivitate, răcire, testare și calificare potrivită pentru a se asigura că acceleratoarele AI sunt fiabile și gata de funcționare. Merită remarcat faptul că, de asemenea, rulează aceste interfețe mult mai rapid decât orice standard actual.

Deține instrumentele software care să-i permită să adune rapid chipleturi

pentru a face IO-urile mai largi sau mai subțiri pentru a se potrivi exact cu

precizia și raportul de care clienții au nevoie pentru sarcinile lor de lucru AI.

Aceasta este flexibilitatea adusă de automatizarea software pe care a

dezvoltat-o de-a lungul anilor. Cunoștințele sale acumulate în ultimul

deceniu de co-dezvoltare XPU o poziționează în mod unic pentru a ne asista rapid clienții. De exemplu, a îmbunătățit fluxurile mecanice, termice și electrice și și-a reglat fin testarea și automatizarea pentru a eficientiza proiectarea și dezvoltarea.

Broadcom are hardware-ul, firmware-ul și software-ul pentru o varietate de soluții de rețea care pot fi incluse în XPU ca chiplete plug-and-play. Acest lucru le permite clienților noștri să emuleze, să simuleze și să ducă acceleratorul la producție mai rapid și mai eficient.

Rezumând: modelul Broadcom personalizat de implicare XPU permite partenerilor să obțină cea mai bună calitate, performanță și TCO reglate pentru sarcinile lor de lucru. Compania are o investiție atât de mare și proactivă în cercetare și dezvoltare – aproximativ 3 miliarde de dolari anual — în crearea tehnologiei viitorului. Marea majoritate a acestei investiții este prioritară pentru piața AI. De exemplu, nucleele sale optice Co Package (dovedite în ultimul XPU) pot economisi 80 de wați de putere de sistem per XPU. Imaginați-vă beneficiile de a pune împreună un milion de aceste acceleratoare cu acele economii de energie și costuri.

Broadcom continuă să fie lideri în domenii precum SERDES de mare viteză, conectivitate cip la cip, memorie de mare viteză, ambalare 2.5 și 3D și time to market, la o cadență anuală sau mai rapidă, în funcție de nevoile clienților. Obiectivul său este să continue să promoveze cea mai bună performanță pentru sarcinile de lucru AI în XPU-uri la cel mai

mic TCO posibil pentru clienții săi.